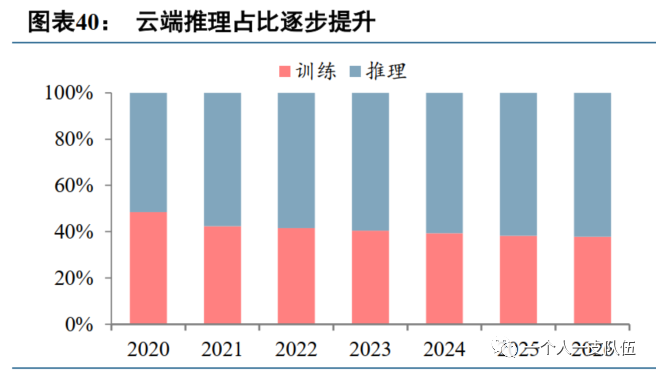

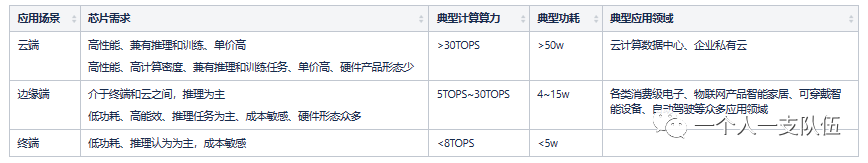

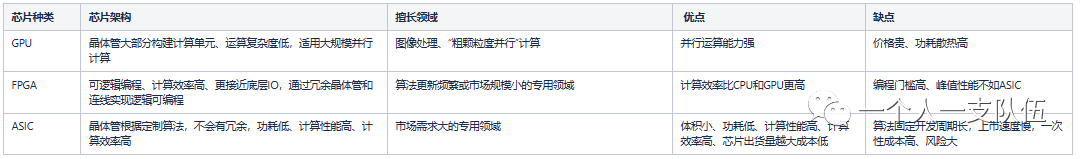

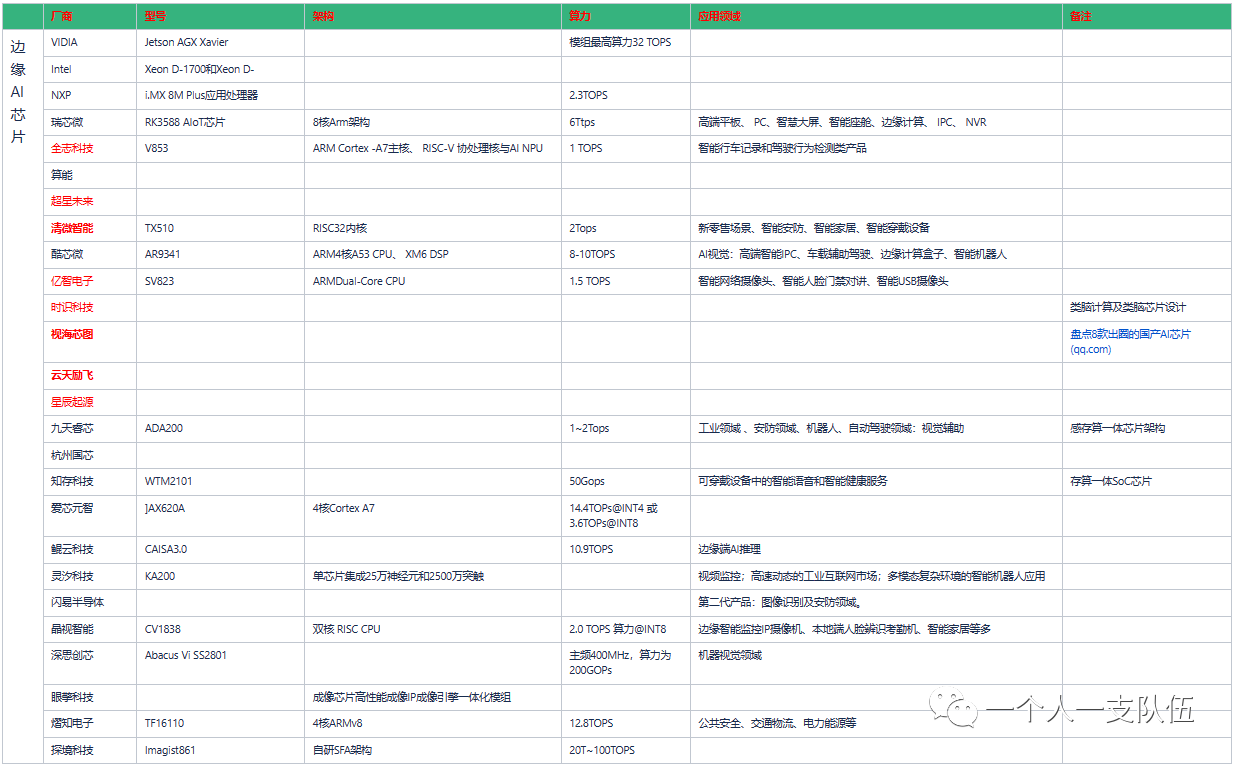

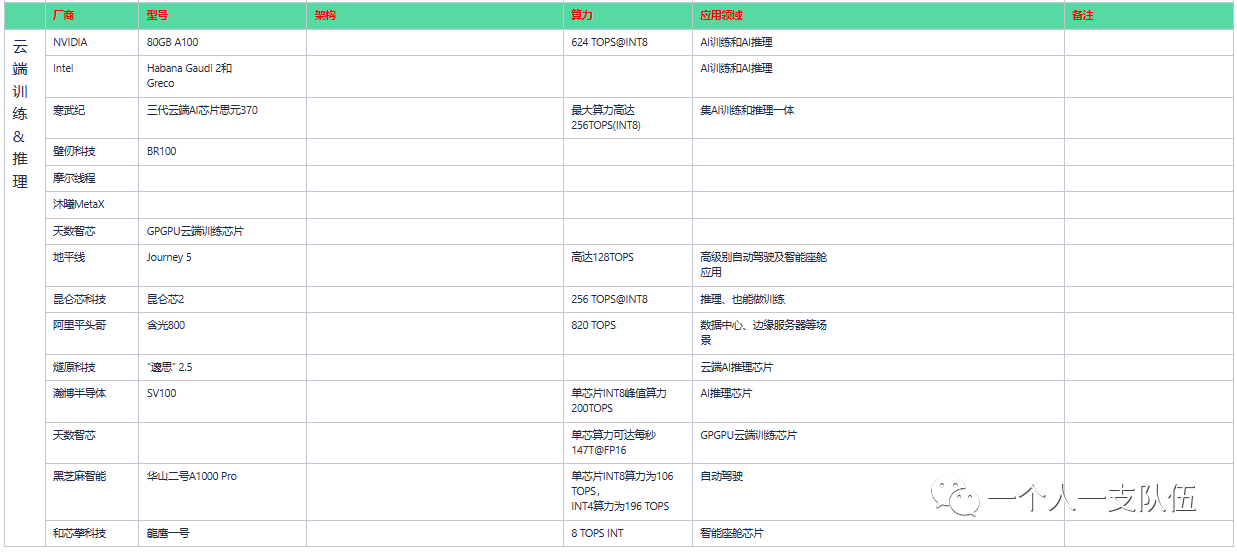

AI 技术在实际应用中包括两个环节:训练(Training)和推理(Inference)。训练是指通过大数据训练出一个复杂的神经网络模型,使其能够适应特定的功能。训练需要较高的计算性能、能够处理海量数据、具有一定的通用性。推理是指利用训练好的神经网络模型进行运算,利用输入的新数据来一次性获得正确结论的过程。 根据所承担任务的不同,AI 芯片可以分为训练 AI 芯片和推理 AI 芯片: (1)训练芯片:用于构建神经网络模型,需要高算力和一定的通用性。 (2)推理芯片:利用神经网络模型进行推理预测,注重综合指标,单位能耗算力、时延、成本等都要考虑。 根据 AI 芯片部署的位置,可以分为云端 AI 芯片和边缘端 AI 芯片: (1)云端:即数据中心,关注算力、扩展能力、兼容性。云端部署的 AI 芯片包括训练芯片和推理芯片。 (2)边缘端:即手机、安防摄像头等领域,关注综合性能,要求低功耗、低延时、低成本。边缘端部署的AI 芯片以实现推理功能为主。 云端推理占比逐步提升,AI 落地应用数量增加。随着人工智能进入大规模落地应用的关键时期,2022 年在云端部署的算力里,推理占算力已经达到了 58.5%,训练占算力只有 41.5%,预计到 2026 年,推理占到 62.2%,训练占 37.8%。云端推理占比逐步提升说明,AI 落地应用数量正在不断增加,人工智能模型将逐步进入广泛投产模式。  1 云端、边缘端AI芯片特性要求边缘计算多元化加速方案建立在GPU、 CPU、 FPGA、 ASIC等硬件基础上,常见的AI加速芯片包括GPU、 FPGA、 ASIC三类:1) GPU用于大量重复计算, 采用并行计算架构, 配备GPU的服务器可取代数百台通用CPU服务器来处理HPC和AI业务。 2) FPGA是一种半定制芯片, 灵活性强集成度高, 但运算量小, 量产成本高, 适用于算法更新频繁或市场规模小的专用领域。 3) ASIC专用性强, 市场需求量大的专用领域, 但开发周期较长且难度极高。 • AI训练: 需要大量数据运算, GPU预计占64%左右市场份额( NVIDIA一家独大) , FPGA和ASIC分别为22%和14%。 • AI推理:无需大量数据运算, 但是对单位功耗算力, 时延, 成本等等指标要求较高。FPGA/ASIC的表现可能更突出, GPU将占据42%左右市场, FPGA和ASIC分别为34%和24%。 云端推理芯片则是百家争鸣, 各有千秋。 • 终端推理:在面向智能手机、 智能摄像头、 机器人/无人机、 自动驾驶、 VR、 智能家居设备、 各种IoT设备等设备的终端推理AI芯片方面, 目前多采用ASIC, 还未形成一家独大的态势。终端的数量庞大, 而且需求差异较大。面向各个细分市场, 研究应用场景, 以应用带动芯片研发及销售。 1.1 不同场景AI能力不同 1.2 GPU&FPGA&ASIC对比  2 芯片厂商 2.1 边缘计算芯片厂商梳理 2.2 云端训练&推理芯片厂商梳理  |